首发文来源:CSDN Golang原生爬虫 简单爬虫实现 不依赖第三方包库 方便理解技术原理 (一)

代码实例地址:https://download.csdn.net/download/superwebmaster/10415730

探索技术的路上本应该自己造轮子,即使市面上有再多的选择,自己动手尝试也是必要的,第一次尝试必然会问题众多,但你不觉得解决他是一件很有成就感的事情吗,这样才能带给你更大的进步和更深刻的领悟。

如果没有写过的并感兴趣的不妨一起来实现一下这个简单的爬虫。

其实用golang实现爬虫是很简单是事情,但也分情况,我们这次的文章就分享一种最简单的爬虫实现方式,用到的官方库如下:

import (

"fmt"

"io"

"io/ioutil"

"net/http"

"os"

"regexp"

"strconv"

"strings"

"time"

)

如果你能单单通过这些库就想到该怎么做了,那你就很棒棒了。

为了让程序能一直运行下去,我们首先要有一个源网页,然后不断爬抓记录新的链接,记录的手段有很多,比如存在数据库、通过redis缓存、存在文本文件,最简单的应该就是存在数据库了,这个看你们的技术偏向了。我打算把爬来的链接储存在文本文件里。

首先,了解自己爬抓的目标,我准备爬取所有的Golang相关答疑或者文章,然后翻来覆去很多网站都感觉不适合做源网址,然后灵机一动,百度一下

然后就用这样作为源网址吧:百度一下 - Golang实现

有了源网址,那下面的事情只要捋顺就好办了。首先我们为了抓取到链接,需要一个正则表达式

var (

regHref = `((ht|f)tps?)://[w]{0,3}.baidu.com/link\?[a-zA-z=0-9-\s]*`

)

因为这个正则表达式我们后面可能会复用,所以可以存到一个全局变量里。

一个爬虫如果不限制分秒爬抓次数,那你的网络肯定会受不了,如果电脑配置不行的话,电脑也会挂掉,所以我们需要写一个计时器,golang已经提供了计时器的包 => time

func Timer() {

t := time.NewTimer(time.Second * 1)

<-t.C

fmt.Print("\n\n\n执行爬抓\n\n")

Timer()

}

为什么要写在一个Timer函数里?当然是用来调用的 /手动滑稽

因为我们存在两种情况,第一次爬取或不是第一次爬取的情况是做不同操作的。那要怎么判断呢?因为我们的链接是储存在txt文件里的,所以我们只需要去查txt文件是不是为空,如果为空就认为他是第一次执行程序,先访问源网址,否则就按照文件里的链接依次访问。

代码如下:

func main() {

if checkFile("./data/", "url.txt").Size() == 0 {

fistStart()

main()

} else {

Timer()

}

}

那我们先看一下firstStart()函数,稍后再解释代码:

func fistStart() {

var num int

url := "http://www.baidu.com/s?ie=utf-8&f=8&rsv_bp=1&tn=39042058_20_oem_dg&wd=golang%E5%AE%9E%E7%8E%B0&oq=golang%2520%25E5%2588%25A0%25E9%2599%25A4%25E6%2595%25B0%25E7%25BB%2584&rsv_pq=d9be28ec0002df1b&rsv_t=8017GWpSLPhDmKilZQ1StC04EVpUAeLEP90NIm%2Bk5pRh5R9o57NHMO8Gaxm1TtSOo%2FvtJj%2B98%2Fsc&rqlang=cn&rsv_enter=1&inputT=3474&rsv_sug3=16&rsv_sug1=11&rsv_sug7=100&rsv_sug2=0&rsv_sug4=4230"

resp, _ := http.Get(url)

defer resp.Body.Close()

body, _ := ioutil.ReadAll(resp.Body)

reg := regexp.MustCompile(`((ht|f)tps?)://[w]{0,3}.baidu.com/link\?[a-zA-z=0-9-\s]*`)

f, _ := os.OpenFile("./data/url.txt", os.O_CREATE|os.O_APPEND|os.O_RDWR, 0666)

defer f.Close()

for _, d := range reg.FindAllString(string(body), -1) {

ff, _ := os.OpenFile("./data/url.txt", os.O_RDWR, 0666)

file, _ := ioutil.ReadAll(ff)

dd := strings.Split(d, "")

dddd := ""

for _, ddd := range dd {

if ddd == "?" {

ddd = `\?`

}

dddd += ddd

}

if checkRegexp(string(file), dddd, 0).(string) == "" {

io.WriteString(f, d+"\n")

fmt.Print("\n收集地址:" + d + "\n")

num++

}

// fmt.Print(string(file))

ff.Close()

}

fmt.Print("\n首次收集网络地址:" + strconv.Itoa(len(reg.FindAllString(string(body), -1))) + "\n")

fmt.Print("\n去重后网络地址数:" + strconv.Itoa(num))

fmt.Print("\n\n首次储存成功!\n")

}

很抱歉,没有注释习惯

其实很简单,就是发起一个get请求,然后你会获取到byte[]类型的数据,转换成string类型之后,就是网页的代码了。

分解一下(了解原理的跳过这段):

url := "http://www.baidu.com/s?ie=utf-8&f=8&rsv_bp=1&tn=39042058_20_oem_dg&wd=golang%E5%AE%9E%E7%8E%B0&oq=golang%2520%25E5%2588%25A0%25E9%2599%25A4%25E6%2595%25B0%25E7%25BB%2584&rsv_pq=d9be28ec0002df1b&rsv_t=8017GWpSLPhDmKilZQ1StC04EVpUAeLEP90NIm%2Bk5pRh5R9o57NHMO8Gaxm1TtSOo%2FvtJj%2B98%2Fsc&rqlang=cn&rsv_enter=1&inputT=3474&rsv_sug3=16&rsv_sug1=11&rsv_sug7=100&rsv_sug2=0&rsv_sug4=4230"

resp, _ := http.Get(url)

defer resp.Body.Close()

body, _ := ioutil.ReadAll(resp.Body)

reg := regexp.MustCompile(`((ht|f)tps?)://[w]{0,3}.baidu.com/link\?[a-zA-z=0-9-\s]*`)

f, _ := os.OpenFile("./data/url.txt", os.O_CREATE|os.O_APPEND|os.O_RDWR, 0666)

defer f.Close()

这段主要是发起一个get网络请求,然后把请求到的byte数据转成stirng类型的数据,跳过正则获取匹配链接获取一个链接数组(不过分赘述,如果还不懂http请求可以另寻百度)

for _, d := range reg.FindAllString(string(body), -1) {

ff, _ := os.OpenFile("./data/url.txt", os.O_RDWR, 0666)

file, _ := ioutil.ReadAll(ff)

dd := strings.Split(d, "")

dddd := ""

for _, ddd := range dd {

if ddd == "?" {

ddd = `\?`

}

dddd += ddd

}

if checkRegexp(string(file), dddd, 0).(string) == "" {

io.WriteString(f, d+"\n")

fmt.Print("\n收集地址:" + d + "\n")

num++

}

// fmt.Print(string(file))

ff.Close()

}

通过循环数组,首先对链接里的特殊符号做特出处理,然后通过checkRegexp函数做查重,就是防止有多个重复链接记录导致浪费资源,最后存入txt文件。

checkRegexp函数:

func checkRegexp(cont string, reg string, style int) (result interface{}) {

check := regexp.MustCompile(reg)

switch style {

case 0:

result = check.FindString(cont)

case 1:

result = check.FindAllString(cont, -1)

default:

result = check.FindAll([]byte(cont), -1)

}

return

}

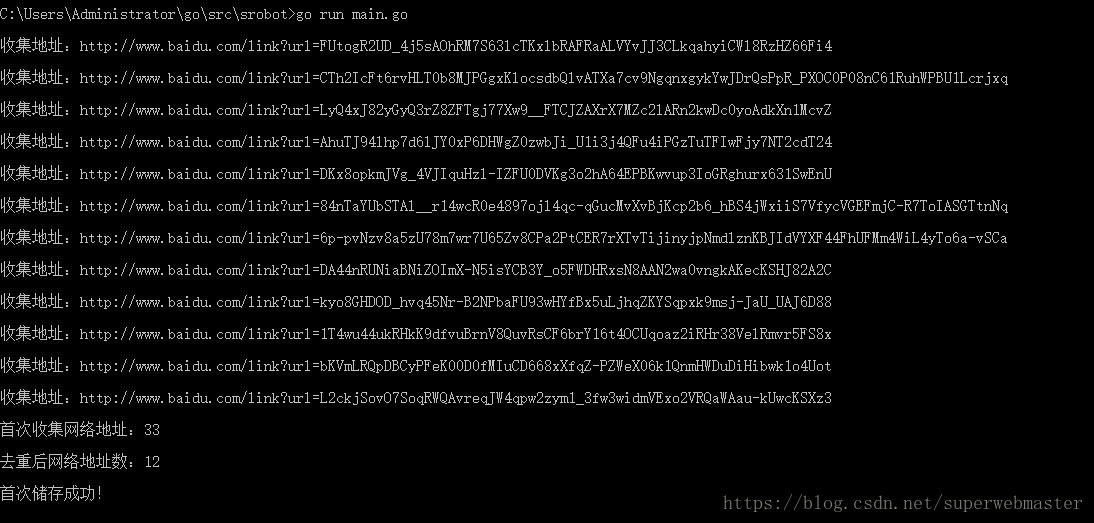

这里,程序的首次执行已经完成,并可以成功记录爬取的链接了。程序执行如下:

下一篇继续讲如何通过这些记录的链接过滤无用爬取有效内容,如果在上面的代码中,还有疑问或发现惊天大Bug可以加我QQ625366394一起解决

有疑问加站长微信联系(非本文作者)