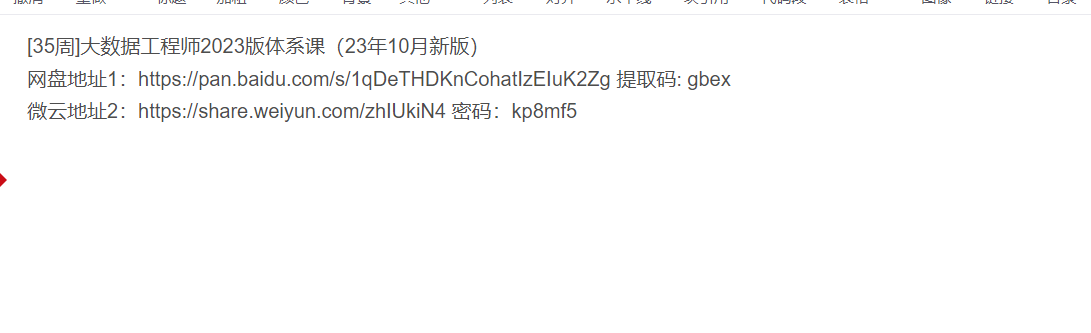

MK体系课-大数据工程师2023版(35周)分享下载,源码+PDF课件+电子手册+软件下载地址+接口数据集,资料齐全下载!

想要学好大数据需掌握以下技术:

1. Java编程技术

2. Linux命令

3. Hadoop

4. Hive

5. Avro与Protobuf

6. ZooKeeper

7. HBase

8.phoenix

9.Redis

10.Flume

11.SSM

12.Kafka

13.Scala

14.Spark

15.Azkaban

16.flink

下面我们就来学习一下HDFS中的一些常见的shell操作

其实hdfs后面支持很多的参数,但是有很多是很少用的,在这里我们把一些常用的带着大家一块学习一下,如果大家后期有一些特殊的需求,可以试着来看一下hdfs的帮助文档

直接在命令行中输入hdfs dfs,可以查看dfs后面可以跟的所有参数

注意:这里面的[]表示是可选项,<>表示是必填项

首先看第一个ls命令

查看hdfs根目录下的内容,什么都不显示,因为默认情况下hdfs中什么都没有

其实后面hdfs的url这一串内容在使用时默认是可以省略的,因为hdfs在执行的时候会根据HDOOP_HOME自动识别配置文件中的fs.defaultFS属性

所以这样简写也是可以的

实战:WordCount案例开发

前面我们通过理论层面详细分析了单词计数的执行流程,下面我们就来实际上手操作一下。

大致流程如下:

第一步:开发Map阶段代码

第二步:开发Reduce阶段代码

第三步:组装Job

在idea中创建WordCountJob类

添加注释,梳理一下需求:

需求:读取hdfs上的hello.txt文件,计算文件中每个单词出现的总次数

hello.txt文件内容如下:

hello you

hello me

最终需要的结果形式如下:

hello 2

me 1

you 1

有疑问加站长微信联系(非本文作者)