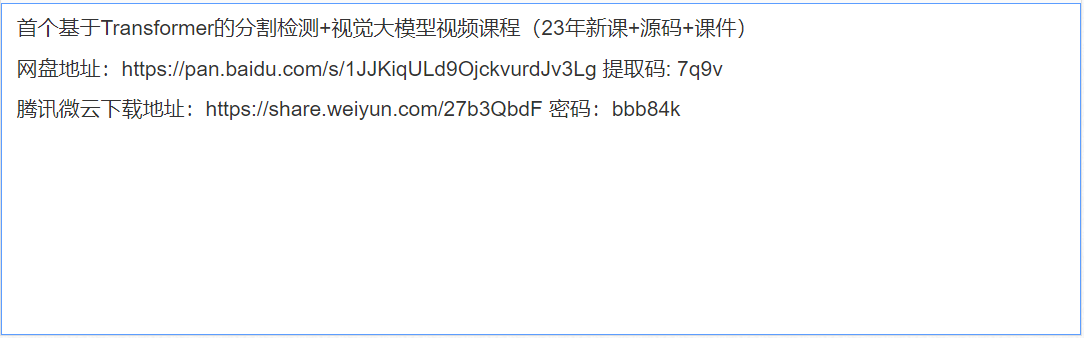

首个基于Transformer的分割检测+视觉大模型视频课程(23年新课+源码+课件)

分享一套视觉大模型课程——首个基于Transformer的分割检测+视觉大模型视频课程,2023年新课,附源码+课件。

视觉分割旨在将图像、视频帧或点云分割为多个片段或组。这种技术具有许多现实世界的应用,如自动驾驶、图像编辑、机器人感知和医学分析。

最近,Transformer成为一种基于自注意力机制的神经网络,最初设计用于自然语言处理,在各种视觉处理任务中明显超越了以往的卷积或循环方法。

具体而言,视觉Transformer为各种分割任务提供了强大、统一甚至更简单的解决方案。本综述全面概述了基于Transformer的视觉分割,总结了最近的进展。

图像分割作为计算机视觉的三大任务之一,是智慧城市、工业制造、自动驾驶等领域的一项关键技术。相比图像分类和目标检测任务,图像分割预测输出目标在像素级别的精细信息,在计算机视觉任务中具有不可替代的作用。

Transformer在计算机视觉领域迅速普及,特别是在目标识别和检测领域。在检查了最先进的目标检测方法的结果后,我们注意到Transformer在几乎每个视频或图像数据集上的表现都优于成熟的基于CNN的检测器。虽然基于Transformer的方法仍然处于小目标检测(SOD)技术的前沿,但本文旨在探索这种广泛的网络提供的性能优势,并确定其SOD优势的潜在原因。由于小目标的低可见性,小目标已被确定为检测框架中最具挑战性的对象类型之一。我们旨在研究可能提高Transformer在SOD中性能的潜在策略。这项综述提出了一个关于已开发的Transformer的SOD任务的60多项研究的分类,跨越2020年至2023年。这些研究涵盖了各种检测应用,包括通用图像、航拍图像、医学图像、主动毫米图像、水下图像和视频中的小目标检测。我们还编译并列出了12个适合SOD的大规模数据集的列表,这些数据集在以前的研究中被忽视了,并使用流行的度量标准(如平均平均精度(mAP)、每秒帧数(FPS)、参数数量等)比较了所评述的研究的性能。

对于目标检测、实例分割、图像分类和许多其他当前的计算机视觉挑战,一个带有Multi-Head Self-Attention的Transformer可能是所有任务都需要的。Transformer在自然语言处理中取得成功后,学习远程特征依赖在计算机视觉中也被证明是一种有效的策略。

通过分析网络入侵行为的数据特征,提出基于Transformer神经网络模型的入侵检测方法。通过在多个数据集上进行实验,选取最优的损失函数和网络结构,最后在测试数据集上,相较于对比机器学习方法,提升训练效率和识别率。主要贡献包括:

1) 针对网络入侵行为数据的时间相关性,提出了一种基于Transformer的网络入侵检测方法,进一步提升网络入侵检测的准确性。 2) 设计一种基于降维特征的多头自注意力机制Transformer网络模型,以解决传统串行化时序神经网络模型不易收敛且时间开销较大问题,通过选取最优损失函数和训练参数进行并行化训练,从而实现网络入侵行为检测。 3) 在多个数据集上进行对比实验,结果表明,提出的基于Transformer网络模型的网络入侵检测方法在多个数据集上均获得了99%以上的精度和检出率。

一种解决方案是使用位置编码来丰富图像特征,在特征层显式地编码位置信息。当将Multi-Head Self-Attention应用于视觉任务时,这已经是常见的做法。Carion和Zhu将绝对2D位置转换,Ramachandran将相对2D位置编码为矢量,并将其求和为注意力计算中的图像特征。

然而,这种方法只能作为图像特征的数据增强。它要求网络在权值内隐式地推断空间信息,由于网络结构中缺乏空间意识,导致在训练时收敛速度较慢。众所周知,网络架构中的归纳偏向提供了强大的学习能力,这已经被著名的架构如卷积神经网络和长短期记忆所证明。

假设在Transformer的注意力模块中可以设计出一个更好的空间感应偏差,那么便可以更好地学习图像特征的表示。

有疑问加站长微信联系(非本文作者)