LLM大语言模型算法特训,带你转型AI大语言模型算法工程师

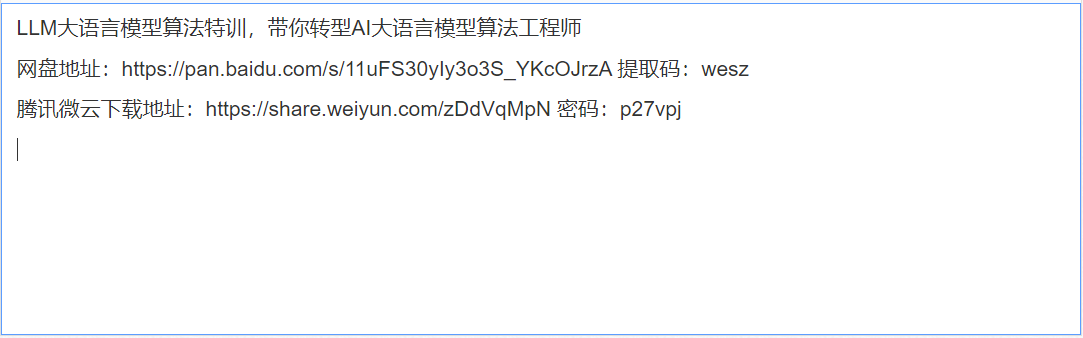

给大家分享一套课程——LLM大语言模型算法特训,带你转型AI大语言模型算法工程师,源码+PDF课件下载。

大语言模型(LLM)是基于海量文本数据训练的深度学习模型。它不仅能够生成自然语言文本,还能够深入理解文本含义,处理各种自然语言任务,如文本摘要、问答、翻译等。

训练语言模型需要向其提供大量的文本数据,模型利用这些数据来学习人类语言的结构、语法和语义。这个过程通常是通过无监督学习完成的,使用一种叫做自我监督学习的技术。在自我监督学习中,模型通过预测序列中的下一个词或标记,为输入的数据生成自己的标签,并给出之前的词。

训练过程包括两个主要步骤:预训练(pre-training)和微调(fine-tuning):

在预训练阶段,模型从一个巨大的、多样化的数据集中学习,通常包含来自不同来源的数十亿词汇,如网站、书籍和文章。这个阶段允许模型学习一般的语言模式和表征。 在微调阶段,模型在与目标任务或领域相关的更具体、更小的数据集上进一步训练。这有助于模型微调其理解,并适应任务的特殊要求。

常见的大语言模型 GPT-3(OpenAI): Generative Pre-trained Transformer 3(GPT-3)是最著名的LLM之一,拥有1750亿个参数。该模型在文本生成、翻译和其他任务中表现出显著的性能,在全球范围内引起了热烈的反响,目前OpenAI已经迭代到了GPT-4版本

BERT(谷歌):Bidirectional Encoder Representations from Transformers(BERT)是另一个流行的LLM,对NLP研究产生了重大影响。该模型使用双向方法从一个词的左右两边捕捉上下文,使得各种任务的性能提高,如情感分析和命名实体识别。

T5(谷歌): 文本到文本转换器(T5)是一个LLM,该模型将所有的NLP任务限定为文本到文本问题,简化了模型适应不同任务的过程。T5在总结、翻译和问题回答等任务中表现出强大的性能。

ERNIE 3.0 文心大模型(百度):百度推出的大语言模型ERNIE 3.0首次在百亿级和千亿级预训练模型中引入大规模知识图谱,提出了海量无监督文本与大规模知识图谱的平行预训练方法。

大语言模型的七大主要功能

生成 Generative LLM最常见的功能之一是根据用户的一个或多个prompts生成内容。主要目标是提高知识工作者的效率,或者替代一些初级人工工作,比如对话式人工智能,聊天机器人,创建营销内容,代码助手等。 相关应用:GPT-3 (和ChatGPT)、LaMDA、Character.ai、 Megatron-Turing NLG – 文本生成尤其适用于与人类对话以及文案、翻译和其他任务;DALL-E、稳定扩散、MidJourney – 基于文本描述生成图像;Anthropic.ai – 专注于通过聊天机器人和其他LLM支持的工具优化销售流程。

总结 Summarization 随着数据量持续爆炸式增长,特别是随着计算机系统本身生成越来越多的内容,拥有良好的摘要变得越来越重要,以便我们人类能够理解所有这些文章、播客、视频和财报电话会议。值得庆幸的是,LLM也可以做到这一点。 其中一种形式是抽象摘要,即生成新颖的文本来表示较长内容中包含的信息。另一种是提取摘要,即根据提示检索到的相关事实被提取并总结为简洁的响应/答案。 相关应用:Assembly AI – 提供音频和视频的转录和摘要;CohereGenerate——基于LLM的产品,可以解释文本并将长段落提炼为主要的几点。

改写 Rewrite 使用LLM将文本从一种形式转换为另一种形式是很常见的大语言模型用途——毕竟这些都是基于Transformer的功能。这样做可以纠正拼写/语法错误或编辑内容。翻译也可以被视为重写的一种形式。 相关应用:Grammarly – 语法错误纠正工具;Google 翻译 – 翻译 100 多种语言。

搜索 Search 传统的搜索类产品通常使用的是基于关键词的算法,有的也采用知识图谱或页面排名风格的方法,来提供用户需求的内容。 这些技术正在逐渐被大语言模型技术替代,例如“神经搜索(neural search)”。它可以更深入地理解语言并找到相关的结果。由于人们现在更常使用长词、短句、明确的问题等多种方式进行搜索,LLM技术在搜索功能中就显得格外重要。 不仅是进行关键词搜索方面需要大语言模型,很多隐性的搜索功能也才逐渐采用LLM来进行更加精准的推荐,如客服机器人,功能推荐,等。 相关应用:Vectara – 由LLM支持的搜索平台,可以根据搜索词/句的意图和含义匹配结果;Neeva – 搜索引擎通过从互联网抓取的数据提供无广告结果

回答问题 Question Answering 回答问题可以被视作是搜索和总结的组合:首先理解用户的询问意图,搜索相关数据,并进行总结,给出一个单一的答案。 LLM的这种Daisy-chaining,即一个模型的输出作为另一个模型的输入,是一种常见的设计,开发者会考虑到不同模型的组合性,并为更多应用创造可能性。 问答功能可以改善客户服务和客户支持结果,帮助总结工作内容,或使销售团队更加高效。 相关应用:Google 搜索、Bing 搜索 – 这两个搜索都会定期尝试在搜索结果列表的顶部提供汇总答案;Contriever – 来自 Facebook Research 的LLM,接受过信息检索和问题解答的训练

聚类 Clustering 聚类是根据文档的内容特征进行分类的功能。该功能不需要客观设定具体分类,LLM会根据内容的特性和理解进行聚类,有助于帮助人们快速理解内容。尤其对于大量数据的预处理、分析方面,会有很大助益。 相关应用:Cohere Embed、Azure Embeddings Models、OpenAI Embeddings Models –这些模型可生成文本嵌入,可用作定制聚类应用程序的基础。

分类 Classification 分类可以将大量数据根据已有的分类系统进行分发,和聚类不同的是聚类不需要预设的分类。分类的用例包括意图分类、情绪检测和危险行为识别。 相关应用:Azure Embeddings Models、OpenAI Embeddings Models – 这些模型可生成文本嵌入,可用作定制分类系统的基础。

大语言模型的优势

自然性:大语言模型能够以一种非常自然的方式理解和生成文本,这使得它们在模仿人类语言行为方面表现出色。

泛化能力:大语言模型能够适应各种不同的语言和语境,具有较强的泛化能力。

高效性:大语言模型可以在较短的时间内处理大量的文本数据,因此在进行大规模文本处理时具有较高的效率。

有疑问加站长微信联系(非本文作者)