以下整理自7月14日第十二期技术分享内容,由 时速云 研发工程师 孟远 分享。

在本次分享开始前,让我们先回想下Pod。Pod直译是豆荚,可以把容器想像成豆荚里的豆子,把一个或多个关系紧密的豆子包在一起就是豆荚(一个Pod)。在k8s中我们不会直接操作容器,而是把容器包装成Pod再进行管理(关于Pod,大家可以参考第二期的分享“谈谈Pod在微服务中的运用”)。Pod是运行服务的基础,那我们如何来管理Pod呢,下面我们就来聊一聊。分为这三个部分:

**1. 使用Replication Controller 来部署、升级Pod**

**2. Replica Set – 下一代Replication Controller**

**3. Deployment – 更加方便的管理Pod和Replica Set**

## 先举个例子

假设我们有一个Pod在提供线上服务,现在有如下几个场景,大家想想如何应对:

1. 节日活动,网站访问量突增

2. 遭到攻击,网站访问量突增

3. 运行Pod的节点发生故障

**第1种情况,** 活动前预先多启动几个Pod,活动结束后再结束掉多余的,虽然要启动和结束的Pod有点多,但也能有条不紊按计划进行

**第2种情况,** 正在睡觉突然手机响了说网站反应特慢卡得要死,赶紧爬起来边扩容边查找攻击模式、封IP等等……

**第3种情况,** 正在休假突然手机又响了说网站上不去,赶紧打开电脑查看原因,启动

新的Pod

Pod需要手动管理,好累……

能否在Pod发生问题时自动恢复呢,我们先来看下Replication Controller(以下简称RC)

先说**RC** 是什么。RC保证在同一时间能够运行指定数量的Pod副本,保证Pod总是可用。如果实际Pod数量比指定的多就结束掉多余的,如果实际数量比指定的少就启动缺少的。当Pod失败、被删除或被终结时RC会自动创建新的Pod来保证副本数量。

所以即使只有一个Pod也应该使用RC来进行管理。

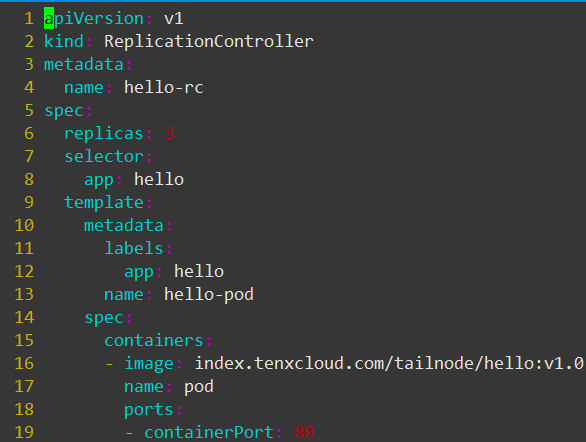

接下来我们看下如何创建RC,看这个定义文件rc.yaml

这个文件定义了RC的属性,我们先关注如下字段:

spec.replicas:副本数量3

spec.selector:RC通过spec.selector来筛选要控制的Pod

spec.template:这里写Pod的定义(但不需要apiVersion和kind)

spec.template.metadata.labels:Pod的label,可以看到这个label与spec.selector相同

这个文件的意思是定义了一个RC对象,它的名字是hello-rc(metadata.name:hello-rc),保证有3个Pod运行(spec.replicas:3),Pod的镜像是index.tenxcloud.com/tailnode/hello:v1.0(spec.template.spec.containers.image: index.tenxcloud.com/tailnode/hello:v1.0)

关键在于spec.selector与spec.template.metadata.labels,这两个字段必须相同,否则下一步创建RC会失败。(也可以不写spec.selector,这样默认与spec.template.metadata.labels相同)

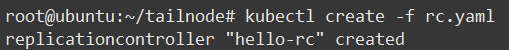

现在通过kubectl来创建RC:

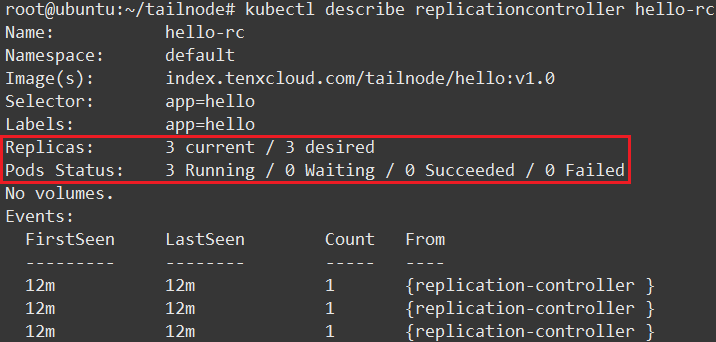

查看结果可以看到当前RC的状态:指定了需要3个Pod、当前实际有3个Pod、3个Pod都在运行中(图片较大只截取部分):

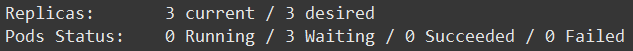

如果使用的镜像较大查看状态可能是Waiting,这是因为正在下载镜像,等待一段时间就好。

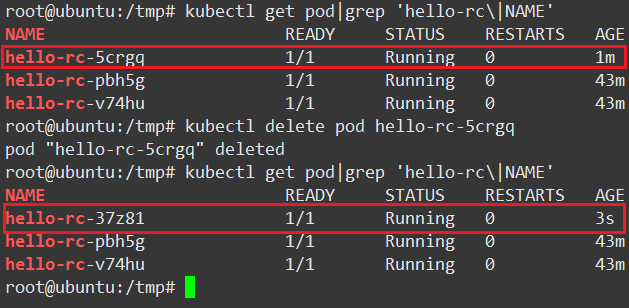

上面说过RC会自动管理Pod保证指定数量副本运行,我们来实验一下,看下图:

1.查看当前Pod,(注意NAME和AGE列)

2.删除hello-rc-5crgq

3.再次查看Pod,发现新的Pod启动了(注意NAME和AGE列)

到这里我们对RC有了基本的认识,并进行了简单的使用。

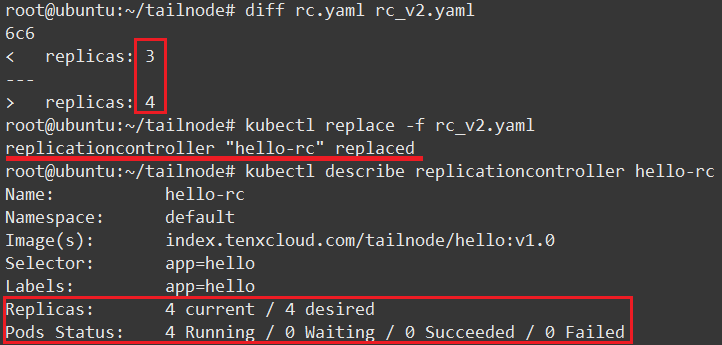

现在回到最开始的问题,如何通过RC修改Pod副本数量。其实非常简单,只需要修改yaml文件spec.replicas字段成想要的值,然后执行kubectl replace命令(或者使用kubect edit replicationcontroller hello-rc直接修改).

执行结果看下图:

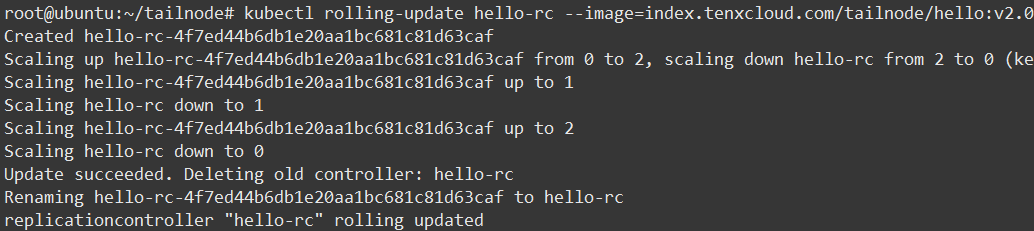

当我们有新功能发布或修复BUG时使用滚动升级是不错的选择,可以使用工具kubectl rolling-update完成这个任务。对照下图我们来看下是如何进行的

使用命令kubectl rolling-update hello-rc –image=index.tenxcloud.com/tailnode/hello:v2.0

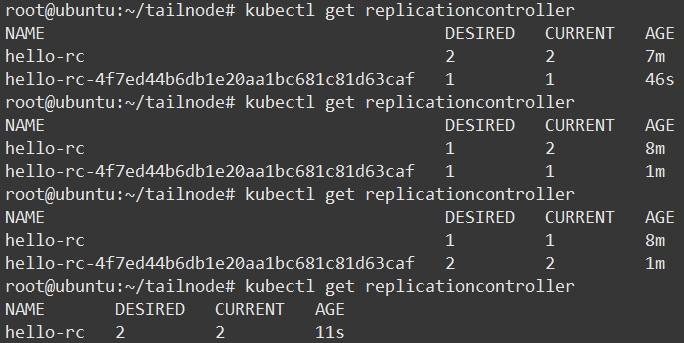

在另一个窗口查看RC

## 对照两张截图,我们能够看出升级步骤如下:

1.创建一个使用新版本Pod的RC,hello-rc-4f7ed44b6db1e20aa1bc681c81d63caf

2.依次增加新RC的副本数量、减少旧RC的副本数量

3.当升级成功后,删除旧RC

4.重命名新RC为hello-rc

当Pod中只有一个容器时通过–image参数指定新的Tag,如果有多个容器或其他字段的修改时,需要使用kubectl rolling-update NAME -f FILE指定文件

如果在升级过程中出现问题(比如长时间无响应),可以CTRL+C结束再使用kubectl rolling-update hello-rc –rollback进行回滚,但如果升级完成后出现问题(比如新版本程序出core),此命令无能为力,需要使用同样方法“升级”为旧版本

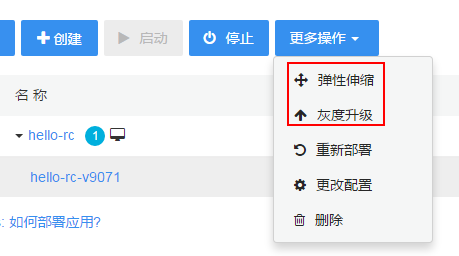

## 在时速云平台我们能够非常方便的使用弹性伸缩功能来调整Pod副本数量,还是举例说明:

启动一个能够输出Pod主机名和版本号的服务,看下图当前只有一个Pod副本运行

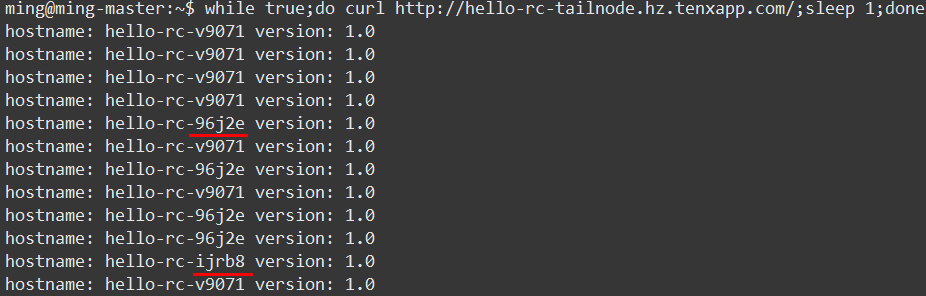

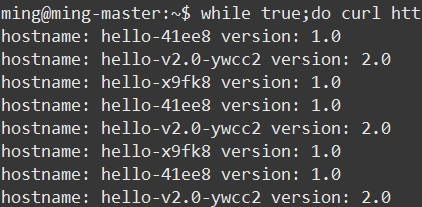

点击弹性伸缩,修改数量为3,同时使用下面的命令测试,从输出结果可以看出提供服务的Pod数量变成了3个:

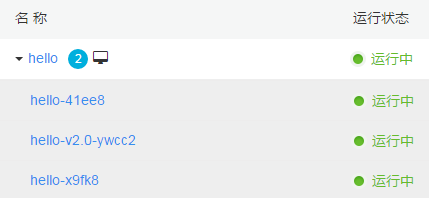

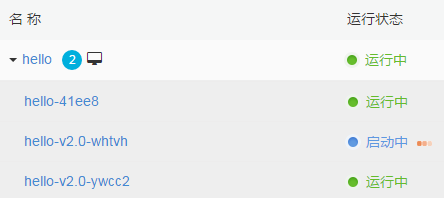

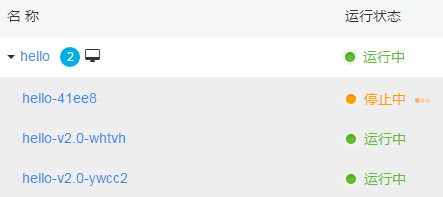

下面再来测试下灰度升级功能,修改目标版本为v2.0(之前是v1.0,为了便于查看效果新建有2个Pod的服务),然后查看Pod变化

第一个新Pod hello-v2.0-ywcc2已经启动

第二个新Pod hello-v2.0-whtvh正在启动

最后一个旧Pod hello-41ee8正在停止

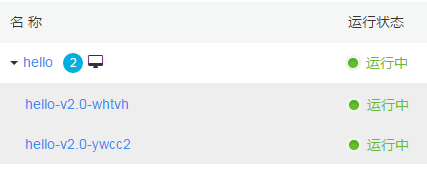

升级完成,只有两个新Pod提供服务

同时使用命令查看服务的响应如下:

k8s是一个高速发展的项目,在新的版本中官方推荐使用Replica Set和Deployment来代替RC。

## 那么它们优势在哪里,我们来看一看:

1. RC只支持基于等式的selector(env=dev或environment!=qa)但Replica Set还支持新的基于集合的selector(version in (v1.0, v2.0)或env notin (dev, qa)),这对复杂的运维管理带来很大方便

2. 使用Deployment升级Pod只需要定义Pod的最终状态,k8s会为你执行必要的操作,虽然能够使用命令kubectl rolling-update完成升级,但它是在客户端与服务端多次交互控制RC完成的,所以REST API中并没有rolling-update的接口,这为定制自己的管理系统带来了一些麻烦。

3. Deployment拥有更加灵活强大的升级、回滚功能

Replica Set目前与RC的区别只是支持的selector不同,后续肯定会加入更多功能。Deployment使用了Replica Set,是更高一层的概念。除非需要自定义升级功能或根本不需要升级Pod,所以推荐使用Deployment而不直接使用Replica Set。

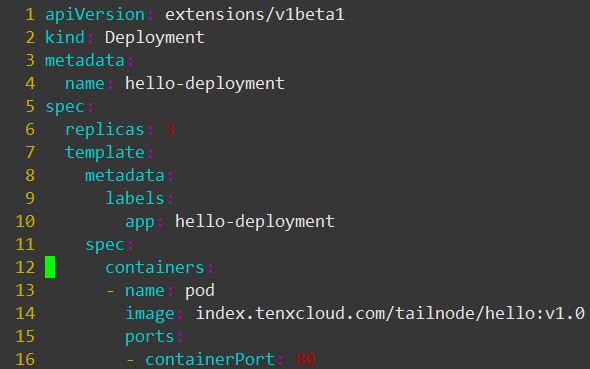

下面我们继续来看Deployment的定义文件,与RC的定义文件基本相同(注意apiVersion还是beta版),所以不再详细解释各字段意思

与创建RC相同,使用命令kubectl create -f deployment.yaml –record创建Deployment,注意–record参数,使用此参数将记录后续对创建的对象的操作,方便管理与问题追溯

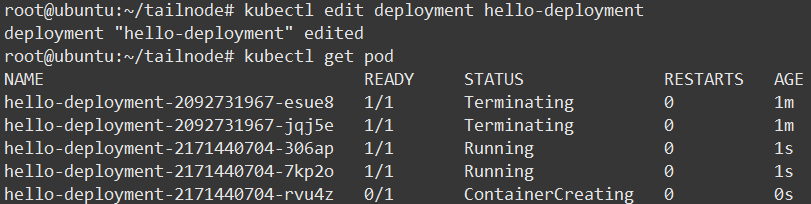

使用kubectl edit deployment hello-deployment修改spec.replicas/spec.template.spec.container.image字段来完成扩容缩容与滚动升级(比kubectl rolling-update速度快很多)

修改image字段为新版本镜像后查看Pod,在STATUS列看到正在执行升级的Pod:

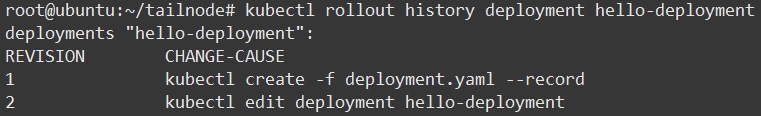

使用kubectl rollout history命令查看Deployment的历史信息

上面提到过kubectl rolling-update升级成功后不能直接回滚,不是很方便,那使用Deployment可以吗,答案是肯定的。

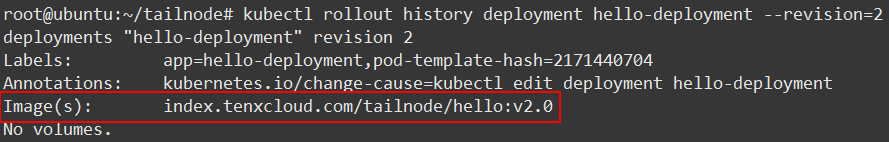

首先在上面的命令加上–revision参数,查看改动详细信息如下:

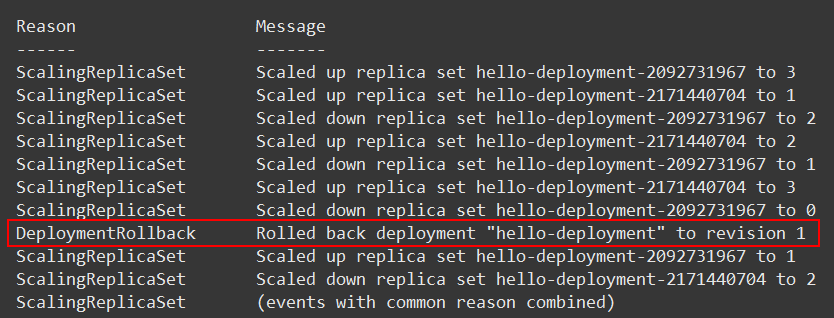

然后使用kubctl rollout undo deployment hello-deployment回滚至前一版本(使用–to-revision参数指定版本)即可。

命令kubectl describe deployment hello-deployment查看详细信息,在Message一列看到回滚如下,详细的信息记录对于问题发生后的原因查找有很大帮助:

通过对比RC、Replica Set与Deployment,可以看出新的Replica Set与Deployment比RC要强大易用很多,但因为现在还是beta版本所以不建议在生产环境使用,不过相信不久的将来我们就能使用上。

## Q&A

1. 问:灰度发布, 可以指定新旧版共存么, 怎么整?

答:可以像上面说的那样,使用命令行工具创建新旧两个RC,然后分别指定需要的Pod数量。但目前时速云平台还不支持这种。

2. 问:时速云是怎么保持k8s master的高可用的?

答:高可用目前是官方推荐的多master standby方式,以及我们自己的agent监管方式。

3. 问:Pod 之间通信是不是也是用的flannel?

答:pod和pod之间,可以采用官方推荐的各种网络解决方案,目前我们主要关注 flannel(vxlan)和 Calico

4. 问:flannel以及calico,你们选其一还是两个方案都在用?有测试报告吗?

答:两个方案都在用,测试报告以前分享过几种方案的网络性能比较,这里有一个Calico的,可以参考:https://www.projectcalico.org/ ... ance/

5. 问:Replica Set 这个有demo的例子么?

答:因为一般Replica Set不会直接使用,而是通过Deployment来控制它,所以本次没有写出Replica Set的demo

6. 问:Deployment现在是没有rest api修改Pod数量么?

答:有的,PUT /apis/extensions/v1beta1/namespaces/{namespace}/deployments/{name}

7. 问:由于k8s严重依赖etcd中的数据,一旦etcd的数据紊乱,可能造成业务故障。这个问题在大量业务接入的时候可能有几率出现,时速云有解决方案吗?

答:这个问题,目前还没有碰到,不过我们会将服务信息同时存放到另外的存储中,也会对etcd进行备份,这样在出现故障时也可以很容易恢复或者迁移整个集群。

8. 问:时速云用的是原生k8s吗,都做了哪些优化?

答:优化是有一些的,包括部署方式、网络、存储、以及一些用户体验上的优化为主,以便充分发挥 k8s 的一些优势。

9. 问:Docker 1.12版本开始集成了Swarm到Docker Engine中,Swarm功能也变得越来越强大,那么时速云怎么看这个问题?以后考不考虑用高版本Docker,用k8s管理集成Swarm的Docker,会不会性能浪费?

答:我们目前主要关注swarm,swarmkit这些docker原生的工具,会去了解他们的主要特性,可以看到swarmkit正在向 k8s 方向迈进。

10. 问:再问个问题,有状态服务的pod,挂载个数据卷(比如rbd)。用rc或者deployment管理的pod重启或者升级以后,数据卷重新挂载到新的pod上会有什么问题么?

答:没有遇到过问题,理论上也不应该会有问题的。

11. 问:能不能介绍一下怎么做用户隔离的,公有云的话,安全对大家很重要

答:可以参考 Calico 的网络隔离和 k8s 的服务、api访问控制,以及一些用户角色上的设计,k8s在安全上还是考虑了不少东西的。

12. 问:容器飘移和虚拟机飘移一样吗?

答:还是不太一样的,虚拟机可以支持热迁移,目前容器还不行。

## 报名方式:

有兴趣参与周四晚8:30-9:30时速云产品、容器技术相关分享的朋友可以添加微信号:时速云小助手(tenxcloud6),我们即可拉您进群~下次分享将于7月28日进行,敬请关注。

有疑问加站长微信联系(非本文作者)